febbraio 8, 2013

Molto rumore per nulla

“Tutti gli animali sono uguali, ma alcuni sono più uguali degli altri”, così disse Napoleone, uno dei personaggi della letteratura distopica classica di George Orwell, La Fattoria degli Animali. La genialità di questa frase risiede nella sua universalità – una piccola modifica capovolge tutto il senso della frase. Aihmè, questo paradosso non è valido solo in contesti letterari, come nella famosa saga agraria sopra citata, ma anche in altri amibiti – non ci crederete – come quello dei test di valutazione dei prodotti anti-virus. Perciò si potrebbe affermare che “tutti i risultati dei test anti-virus pubblicati sono uguali, ma alcuni sono più uguali degli altri”. In effetti, gli astuti esperti di marketing con la loro magia, ‘processano’ i risultati dei test e il prodotto finale – i risultati dei test pubblicati da certe aziende anti-virus – difficilmente si possono considerare equi: i dati vengono manipolati fino a tal punto che perdono ogni significato.

Prendiamo come esempio un’azienda anti-virus ipotetica (una di quelle che, rispetto alla concorrenza, non si distingue particolarmente per le sue abilità tecnologiche o per la qualità della protezione anti-virus che offre), ma con una grande ambizione ed un grande volume di vendite. Perciò qual’è il primo passo per dominare il mondo? Migliorare la tecnologia anti-virus, espandere il data base e aumentare la qualità e la velocità di rilevamento delle minacce? No, assolutamente no. Ci vorrebbe troppo tempo e costerebbe troppo. Per usare una metafora calcistica, non è difficile arrivare nella ‘prima divisione del campionato anti-virus’, ma quanto più ci si avvicina alle prime posizioni della ‘Champions League della Sicurezza IT’, quanti più soldi sarà necessario investire per ottenere un’alta percentuale di rilevamento di virus, senza dimenticare che servono sempre menti brillanti.

Se ne deduce che è molto più economico e veloce intraprendere un’altra strada – non quella tecnologica, ma quella del marketing. Una insufficente padronanza tecnologica e una bassa percentuale di rilevamento di virus vengono spesso compensate da una astuta strategia informativa.

Ma in che modo?

Vediamo un po’…

Qual’è il modo migliore per valutare la qualità della protezione che i prodotti antivirus forniscono? Ovviamente attraverso fonti indipendenti e oggettive. Analisti, clienti e partners sono affidabili, ma la loro imparzialità non può essere garantita. Test comparativi condotti da fonti indipendenti e laboratori specializzati sono le fonti che dovrebbero fornire queste informazioni. Tuttavia si concentrano solo nel loro mercato – il test – il che è una cosa positiva, se il test viene condotto bene, con cura e nel modo appropriato. Ma non è sempre così. Sembra che i risultati siano troppo… noiosi, mentre dovrebbero essere più colorati. E qui è dove entrano in gioco le strategie di marketing: i dati dei test, in realtà obiettivi, vengono truccati per far sì che i primi appaiano secondi. Tutto questo mi ricorda un antica parabola indiana che vede protagonisti un uomo ceco ed un elefante. Viene spesso utilizzata per illustrare l’incapacità dell’uomo di conoscere la totalità della realtà. Gli esperti di marketing sono come i gruppi di cechi del racconto che toccano il corpo dell’elefante: ognuno tocca una parte diversa, ‘percepisce’ solo un frammento del totale e poi si rendono conto che le versioni non coincidono.

La manipolazione dei dati non è un crimine. Tuttavia non è sempre facile separare il vero dal falso. Per esempio, è facile selezionare i dati che più ci piacciono apparsi in un test poco professionale (come può essere il test sull’uso delle risorse di sistema) e omettere i dati non positivi, ma importanti (como il rilevamento o il non rilevamento di un malware). In questo modo paragoniamo i prodotti solo attraverso l’uso che fanno delle risorse. In seguito, il gruppo di marketing lancia una campagna che tiene in considerazione questa caratteristica (l’uso delle risorse) come elemento di differenziazione. Vi dò un altro esempio: una determinata azienda antivirus paragona uno dei suoi nuovi prodotti con una versione precedente offerta dalla concorrenza. Non sto scherzando! Queste cose accadono veramente. È incredibile, vero?

Il fatto è che non si tratta di vere e proprie bugie, ma di una manipulazione ‘selettiva’ dei dati -scegliendo tra loro quelli più favorevoli. Questo è un settore in cui l’etica non esiste. E dato che non ci sono misure legali per controllarla, quello che ci rimane è chiedere a voi di essere vigili e di filtrare le informazioni diffuse in tutto il mondo dalle agenzie di marketing. Se non lo facciamo, si corre il rischio di finire col montare un grande battage pubblicitario e di perdere la fiducia nei test e nell’industria di sicurezza informatica in toto.

La questione dei test condotti dai centri di valutazione è già stata discussa in questa sede. Oggi, esamineremo più da vicino i trucchetti messi a punto dai rappresentanti del mondo del marketing e vedremo come è possibile riconoscerli e combatterli. Elenchiamoli uno per uno…

1. Centri poco trasparenti. I laboratori dove si realizzano le valutazioni ed i controlli di qualità sull’individuazione dei malware sono spesso poco trasparenti. Questo forse è l’ultimo e il più piccolo dei mali. Questo è il caso delle piccole aziende anti-virus o dei fornitori tecnologicamente poco competitivi. Queste cercano un finto-laboratorio, conosciuto come “centro di valutazione”, senza alcuna esperienza documentata a livello professionale. Non hanno molti soldi, la metodologia di solito non viene resa nota, cercare i risultati è impossibile e finiscono col correre molti rischi a livello di reputazione.

Conclusione: se i risultati delle valutazioni non includono una descrizione della metodologia usata e la metodologia contempla molti ‘bug’ o errori, i risultati dei test non sono attendibili.

2. Riutilizzo di vecchi test. Perché superare i test di verifica anno dopo anno quando è possibile superarne uno ogni due o tre anni, e poi per molto tempo andare avanti vantandosi di quell’unico risultato ottenuto?

Conclusione: controlla la data del test del prodotto. Se lo studio è vecchio o non c’è il link alla fonte (i dati sono pubblici e devono essere corredati dalla data di pubblicazione), il test non è attendibile. Non ti fidare.

3. Paragone con le vecchie versioni. Ci sono due possibilità. La prima: comparazione tra due o più prodotti vecchi. In questo caso una compagnia anti-virus determinata viene sorprendentemente dichiarata vincitrice. Ovviamente, nel frattempo, l’industria si è evoluta, migliorando le sue tecniche nella lotta contro i virus. Secondo: comparazione del prodotto di una compagnia antivirus determinata con le vecchie versioni del prodotto della concorrenza. Questo è un colpo basso!

Conclusione: fate sempre attenzione alla versione del prodotto che acquistate. Se ci sono delle discrepanze sicuramente vi stanno fregando. Perciò, dimenticate anche questi risultati.

4. Comparare l’incomparabile. Qual’è il modo migliore per dimostrare le tue abilità tecnologiche? Facile! Comparare l’incomparabile in una o due aree determinate! Per esempio prodotti che appartengono a diverse categorie (business e home) o differenziare tecnologie di protezione (per esempio, approcci con o senza ‘agenti’ per la protezione degli ambienti virtuali).

Conclusione: fai attenzione non solo alle versioni e dalle date di emissione dei prodotti comparati, ma anche ai titoli dei prodotti.

5. Enfatizzare esageratamente alcune caratteristiche senza menzionarne altre. Non hai superato un test? Non hai superato tutti i test? Nessun problema. Ci pensano le agenzie di marketing specializzate nelle prove di verifica dei prodotti. La ricetta è semplice: prendi una funzionalità specifica (la velocità di scansione o il basso consumo delle risorse di sistema), sottolinea solo questa caratteristica e esaltala in tutta la pubblicità che lanci nel mondo, come se fosse una prova della grandezza del tuo prodotto. Un esempio? Eccolo.

Conclusione: se solo viene pubblicizzata la “velocità, l’efficenza e il prezzo”, è una frode bella e buona.

6. Uso di metodologie irrilevanti. Qui potremmo menzionare un numero molto alto di manovre poco pulite. In genere l’utente medio non legge nei dettagli la metodologia utilizzata per la valutazione del prodotto (hanno di meglio da fare). Tuttavia, il diavolo è sempre in agguato (e si nasconde soprattutto nei dettagli) e quello che spesso succede è che i test non corrispondono con le condizioni del mondo reale e non riflettono la qualità della protezione anti-virus nel mondo reale. Un altro esempio: ponderazione soggettiva dell’importanza dei parametri di valutazione dei test.

Conclusione: se si comparano mele con pere, anche tu puoi comparare il risultati di tali test con… i risultati del test relativo alla forza dello sciacquone del water. L’utilità della comparazione è più o meno la stessa.

7. Valutazione selettiva. Questo comporta uno sforzo analitico notevole e richiede un’ampia esperienza e abilità nell’arte del raggiro 🙂 Per selezionare i punti forti del prodotto in diversi test si utilizzano statistiche e tecnologie e dopo di chè si effettua un’analisi comparativa che impiega i metodi descritti anteriormente. Un chiaro esempio lo potrete trovare cliccando qui.

Conclusione: “Se hai intenzione di mentire, sii breve” ©! Se si dilungano troppo e non vanno al punto, la risposta è ovvia.

8. Imbroglio assicurato. Anche in questo punto potremmo menzionare molti casi. Il più diffuso è rubare ottimi prodotti di rilevamento per specifici test. Nel settore anti-virus succede spesso di discutere delle varie forme di imbroglio. Per esempio, sembra che uno sviluppatore anonimo ha fornito ad un centro di valutazione una versione speciale del suo prodotto, che funzionava solo in un particolare ambiente. Il trucco era facile: per compensare la sua incapacità di rilevare tutti i file infetti durante la prova di verifica, il prodotto rilevò tutti i file presenti nel sistema. Ovviamente, questo produsse un numero anormale difalsi positivi. Ma volete sapere una cosa? L’articolo di marketing non ha detto una sola parola rispetto a tutto ciò.

Conclusione: solo i professionisti possono catturare gli imbroglioni. La maggior parte degli utenti, sfortunatamente, non possono. Perciò che possiamo fare? Se un test di un prodotto mostra un risultato eccellente e in un altro non lo mostra, è una prova che ci stanno fregando.

9. Rifiutarsi di partecipare ad un test – ultimo trucco, il più semplice. E’ facile rifiutarsi di partecipare ad un test o vietare al valutatore di pubblicare il nome del prodotto, usando al suo posto “fornitore A”, “fornitore B”, ecc. Perciò, perché partecipare ad un test che ci farà fare brutta figura? Se il nome di un prodotto sparisce dalla lista dei prodotti testati, non è un prodotto affidabile.

Conclusione: verifica che un determinato prodotto abbia pertecipato a tutti controlli di qualità del prodotto. Se partecipa solo in quelli dove si decantano i suoi meriti e non viene nominato nessun problema, non ti fidare. Il marketing ne starà combinando di nuovo una delle sue.

Comunque sia, se qualche lettore di questo blog volesse fare una ricerca su qualche risultato relativo ai test condotti su un determinato software anti-virus e si imbatte in qualche trucchetto di marketing tra quelli menzionati anteriormente, non sia timido: per favore, lascia un commento. Prometto di considerarlo e di parlare con i responsabili 🙂

Ed ora, per ricapitolare, ecco cosa un utente deve fare, di chi si deve fidare e come leggere tavole, test e grafici (ne abbiamo già parlato in un post precedente). Di seguito, quindi, alcuni consigli sul come leggere i risultati dei test e smascherare gli imbrogli del marketing:

- Controlla la data del test, la versione e le caratteristiche del prodotto testato.

- Controlla la ‘cronologia’ con cui il test è apparso nei test.

- Non soffermarti solo su di una funzionalità. Controlla tutte le caratterisctihe del prodotto, e soprattutto, la qualità della protezione.

- Dai un’occhiata alla metodologia con cui è stato condotto il test e la reputazione del centro che lo ha realizzato.

Rispetto al punto numero 4, non riguarda tutti gli utenti, forse solo gli specialisti. Per i non specialisti, raccomando di dare un’occhiata alla seguente lista di centri di verifica. Sono laboratori rispettabili, con molti anni di esperienza nell’industria, che lavorano con metodologie note e testate e che rispettano gli standard della AMTO (Anti-Malware Testing Standards Organization).

Ma prima voglio dirvi che noi non sempre siamo ai primi posti nelle prove dei valutatori. Ma mi fido della loro professionalità.

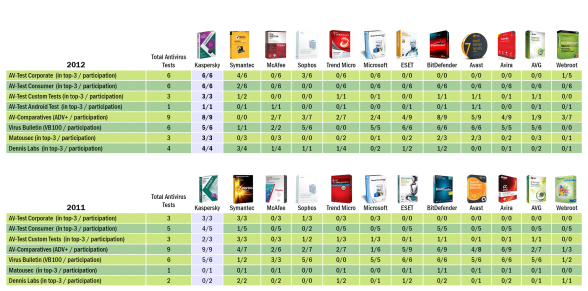

Ed ora, per coloro che desiderano maggiori informazioni, il ranking dei centri di valutazioni relativi al periodo 2011.2012:

Ed infine infine – sì, siamo davvero in chiusura – un riassunto di quanto detto fin’ora:

Probabilmente qualcuno penserà che quanto detto fino ad adesso non è altro che cattiva pubblicità per la concorrenza. Quello che invece volevo fare è affrontare un tema su cui si discute da anni e su cui non si è ancora trovata una soluzione. In particolare, mi interessa sottolineare che non esistono metodologie intelligibili e stabilite con cui condurre i test comparativi dei prodotti antivirus e quelle esistenti non sono completamente comprese né dall’utente, né dagli sviluppatori!

Nel frattempo, mantenetevi informati ma non chiudete gli occhi sul problema. Potete stare certi che la ‘manipolazione creativa’ di statistiche ha comunque dei limiti. Gli utenti devono semplicemente scegliere con attenzione, leggendo con occhio critico i dati, e separando il vero dal falso. Purtroppo non tutti hanno il tempo e la pazienza per farlo, è comprensibile.

La mia ultima parola è: occhi aperti!